Il “deep learning” studia le interazioni sociali fra animali

Il “deep learning” studia le interazioni sociali fra animali

Passi da gigante dei ricercatori dell’EPFL nel tracciamento video, assistito dal computer, del comportamento della fauna quando è in… comunità

I ricercatori del Politecnico Federale di Losanna hanno compiuto passi da gigante nel tracking degli animali assistito dal computer, espandendo le potenzialità del loro software, già noto nel mondo con il nome di DeepLabCut, per offrire un tracciamento video ad alte prestazioni della condotta di svariate forme di vita.

La capacità di catturare il comportamento animale è fondamentale per le neuroscienze, l’ecologia e in molti altri campi.

Le telecamere sono ideali per studiare a grana fine il loro modo di agire, ma lo sviluppo di tecniche di computer vision funzionali ad estrarre e a comprendere ciò che altre forme di vita fanno è molto impegnativo, anche se tutto ciò non sembra apparentemente richiedere particolari sforzi al nostro sistema visivo.

La “ricetta” dell’EPFL per computer quantistici più potenti

Dell’orientamento delle parti del corpo di un essere vivente

Uno degli aspetti chiave della quantificazione del comportamento degli animali è la cosiddetta “stima della posa”, che si riferisce alla capacità di un computer di identificare la posizione e l’orientamento di diverse parti del corpo di un essere vivente.

In un ambiente di laboratorio, è possibile aiutare la “stima della posa” collocando dei marcatori sul corpo dell’animale come nelle tecniche di motion-capture usate nei film (si pensi a “Gollum” nel kolossal “Il Signore degli Anelli”…).

Come si può immaginare, far sì che gli animali indossino attrezzature speciali non è il compito più facile di questo mondo: spesso è assolutamente impossibile, ed è altrettanto poco etico.

Per questo motivo, i professori Alexander Mathis e Mackenzie Mathis dell’EPFL sono stati i pionieri del tracciamento “senza marcatori” degli animali e dei loro movimenti.

Il software made-in-Vaud si basa sull’apprendimento profondo per “insegnare” ai computer a eseguire la “stima della posa” senza la necessità di marcatori fisici o virtuali.

Verso un neurone artificiale quantistico grazie ai fotoni

Oltre 350.00 download del programma e quasi 1400 citazioni

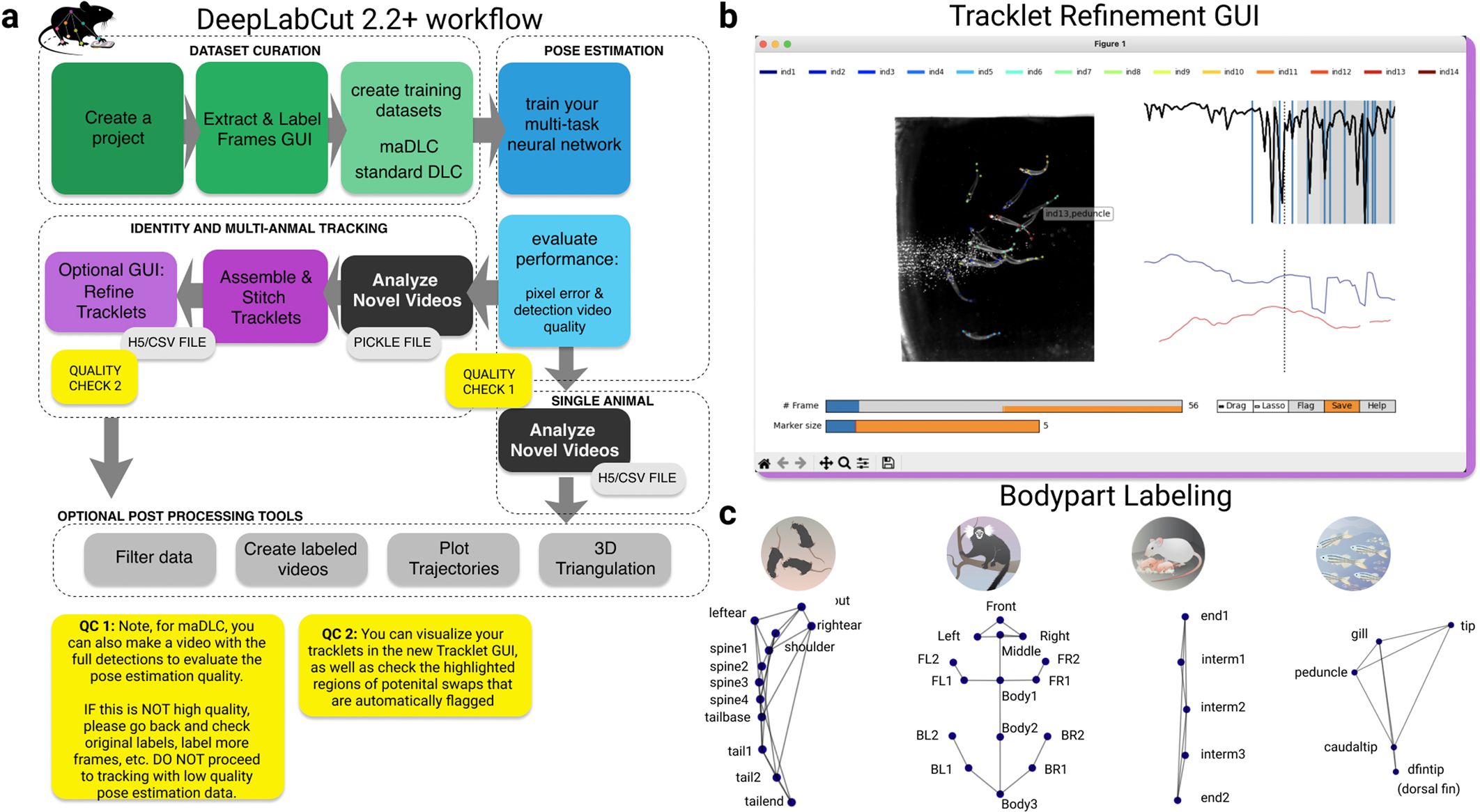

I loro team di lavoro hanno sviluppato DeepLabCut, un “pacchetto di “stima della posa” degli animali” open source e ad apprendimento profondo, che può eseguire senza marcatori la cattura del movimento di ogni forma di vita.

Nel 2018 hanno rilasciato DeepLabCut, e il software ha ottenuto una performance significativa nel campo delle scienze della vita: oltre 350.000 download del programma e quasi 1.400 citazioni.

Poi, nel 2020, le équipe dei due omonimi scienziati Mathis hanno rilasciato “DeepLabCut-Live!”, una versione in tempo reale a bassa latenza di DeepLabCut, che consente ai ricercatori di ricevere rapidamente un feedback sugli animali che stanno studiando.

Così i “rail pads” EMPA riducono il rumore lungo le ferrovie

Una nuova sfida nella “stima della posa”: le bestie fra i simili

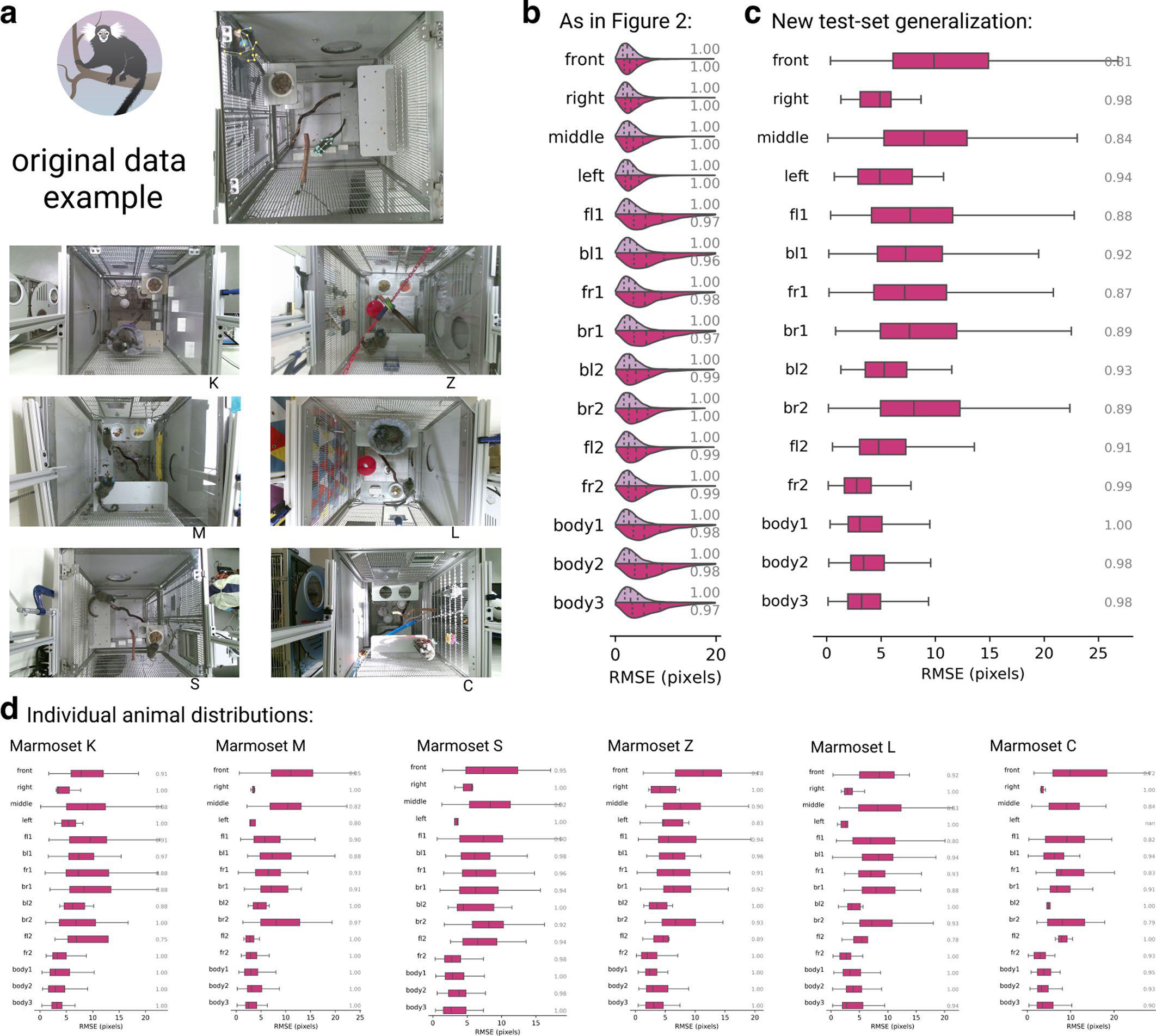

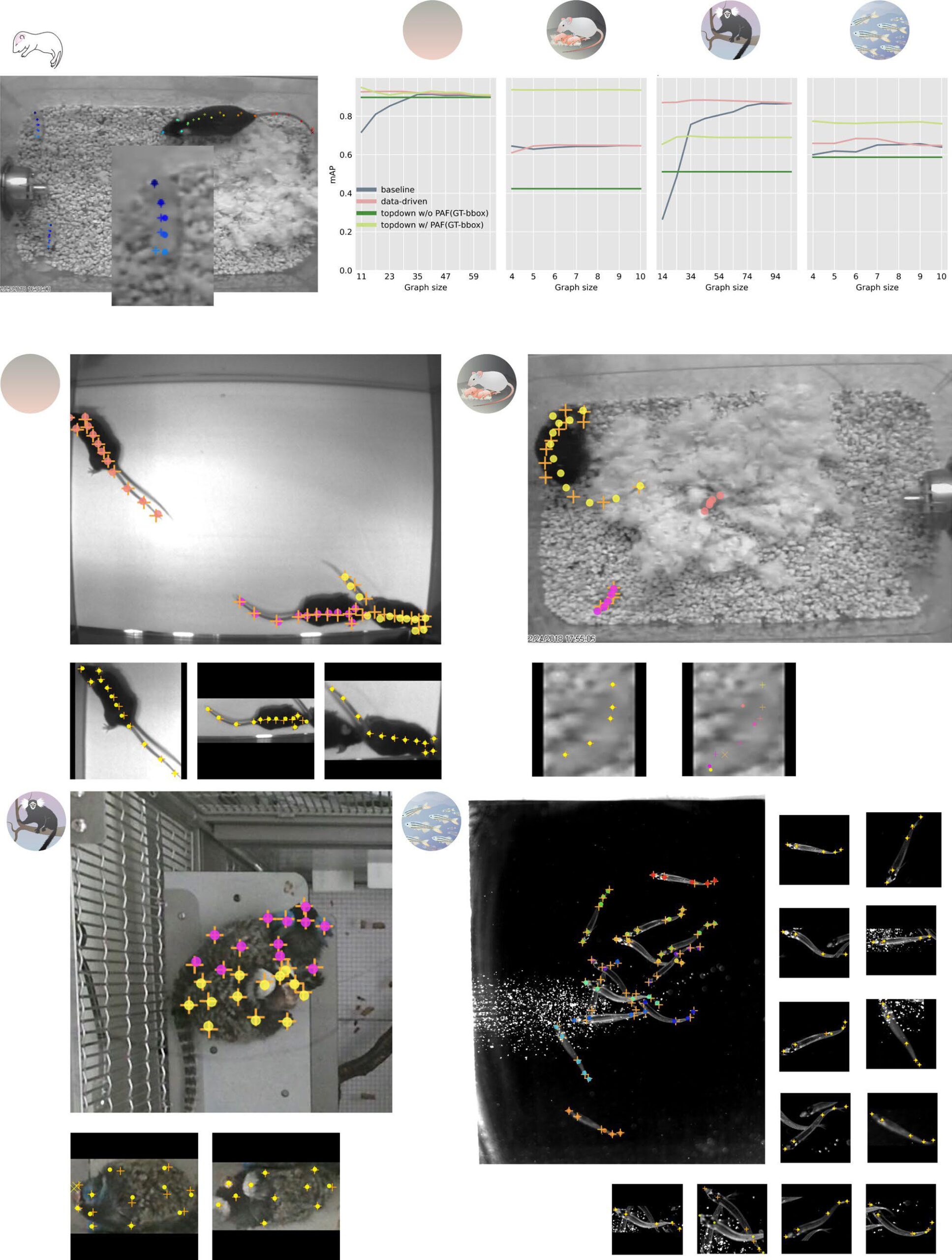

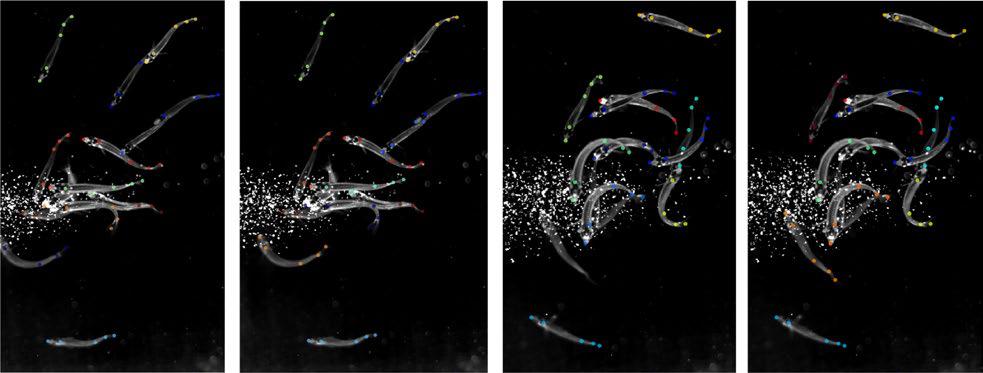

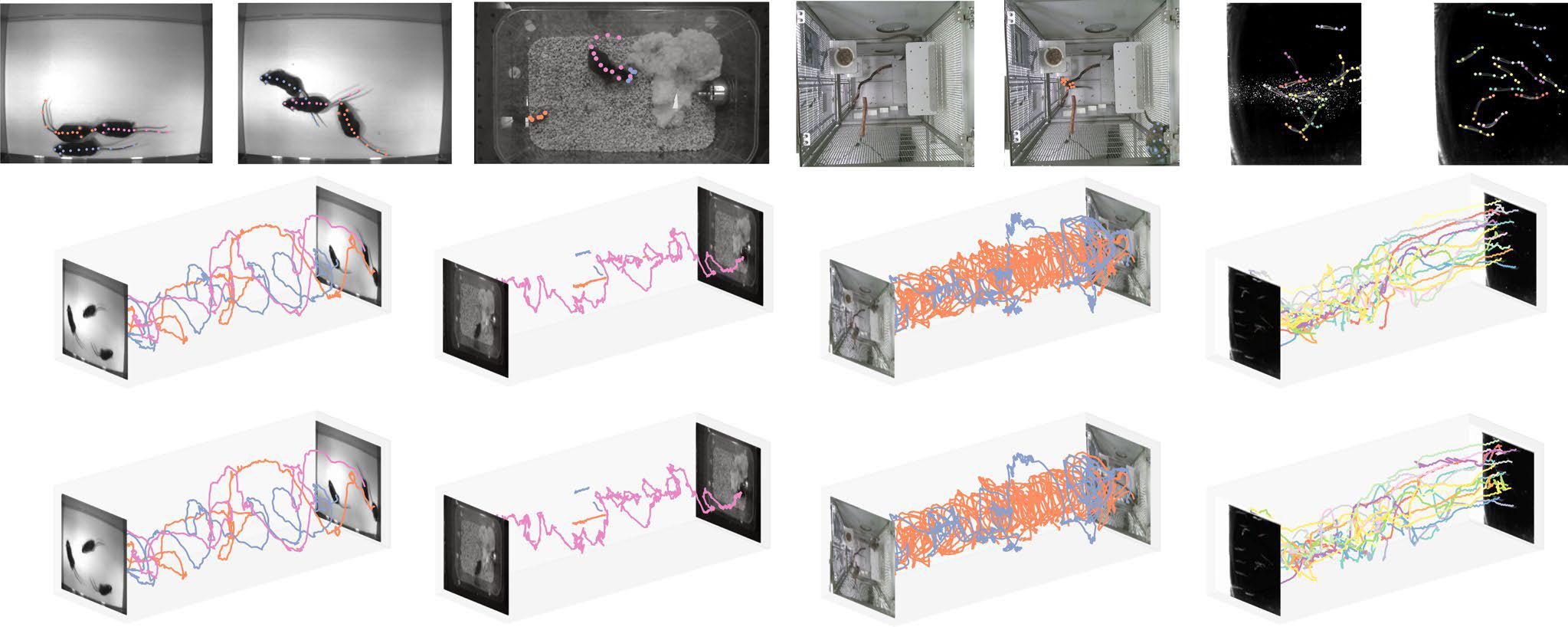

Ora, gli scienziati hanno ulteriormente ampliato DeepLabCut per affrontare un’altra sfida nella sfida nella “stima della posa”: il monitoraggio degli animali sociali, anche quelli strettamente interagenti; ad esempio, i topi che agiscono da genitori dei loro cuccioli o gli avannotti, i “cuccioli” dei pesci in fase di apprendimento.

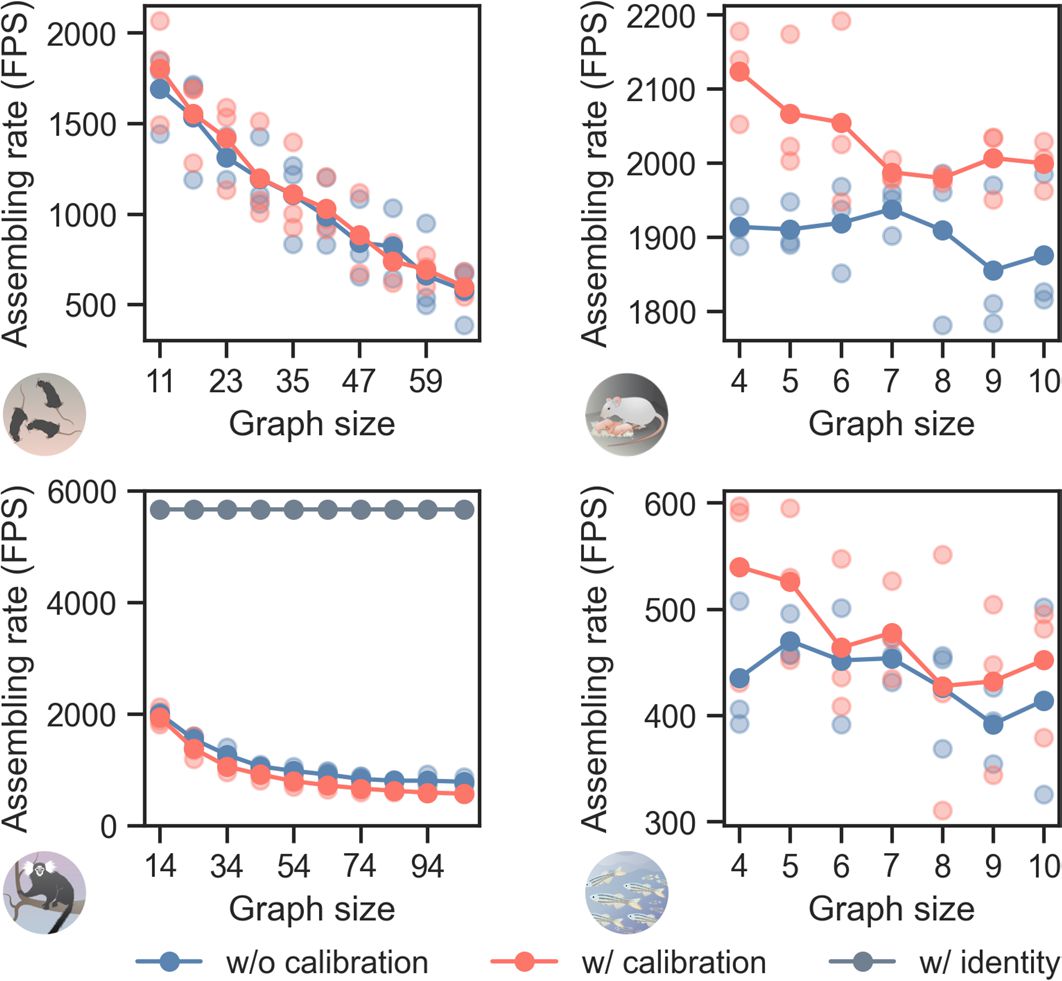

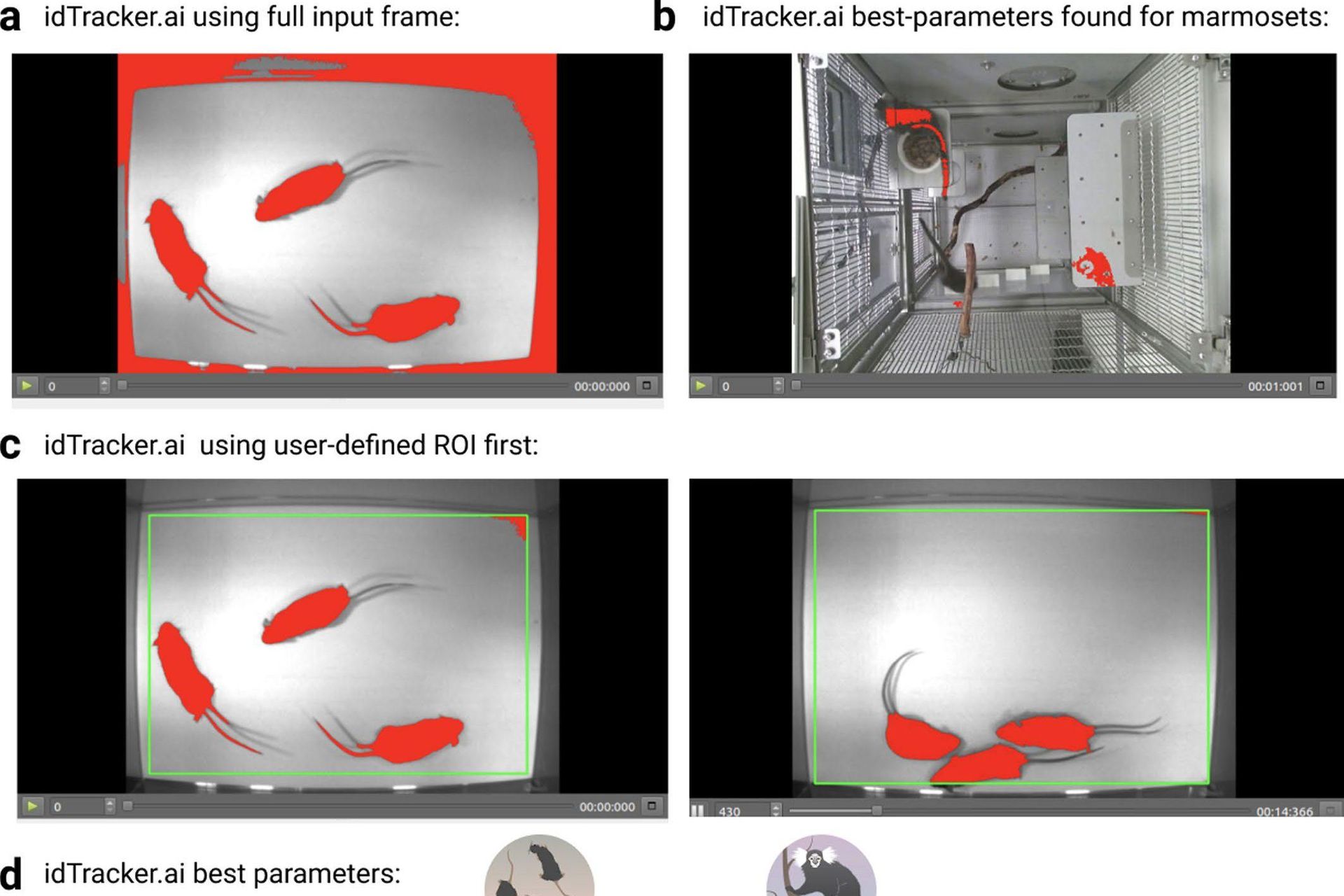

Le sfide qui sono ovvie: i singoli animali possono essere così simili da confondere il computer, possono oscurarsi a vicenda, e ci possono essere molti “punti chiave” che i ricercatori vogliono tracciare, rendendo computazionalmente difficile un’elaborazione efficiente delle informazioni.

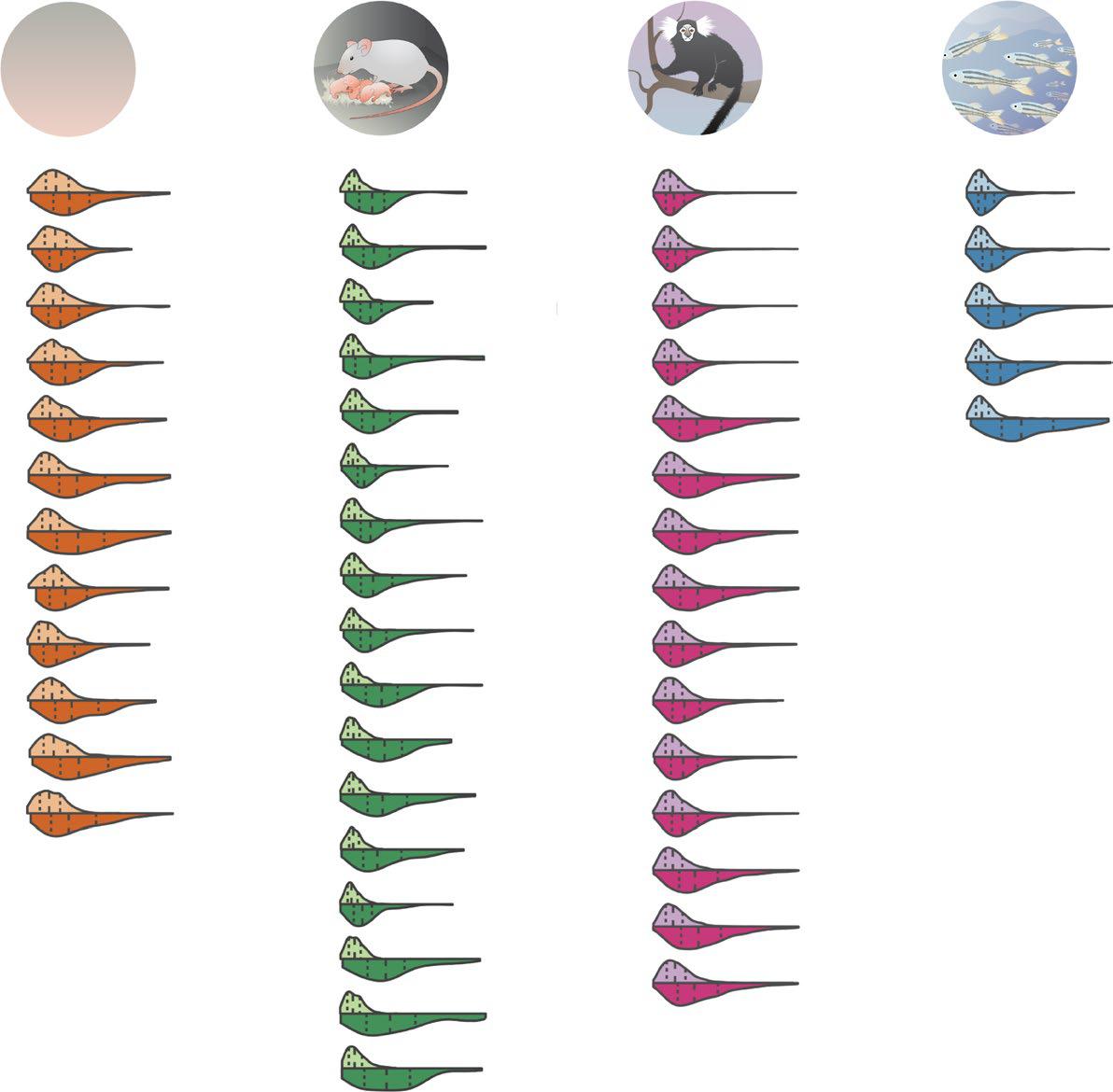

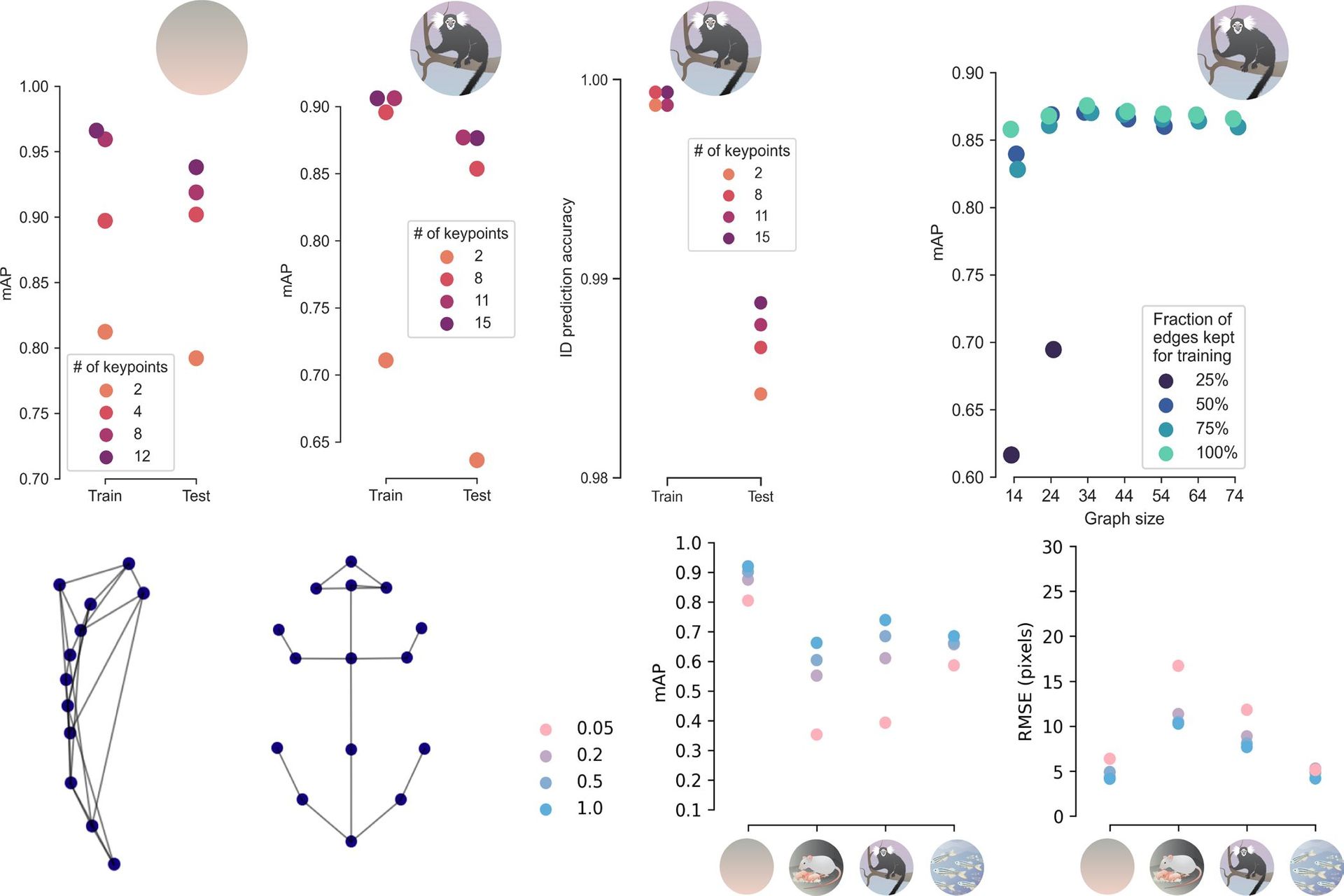

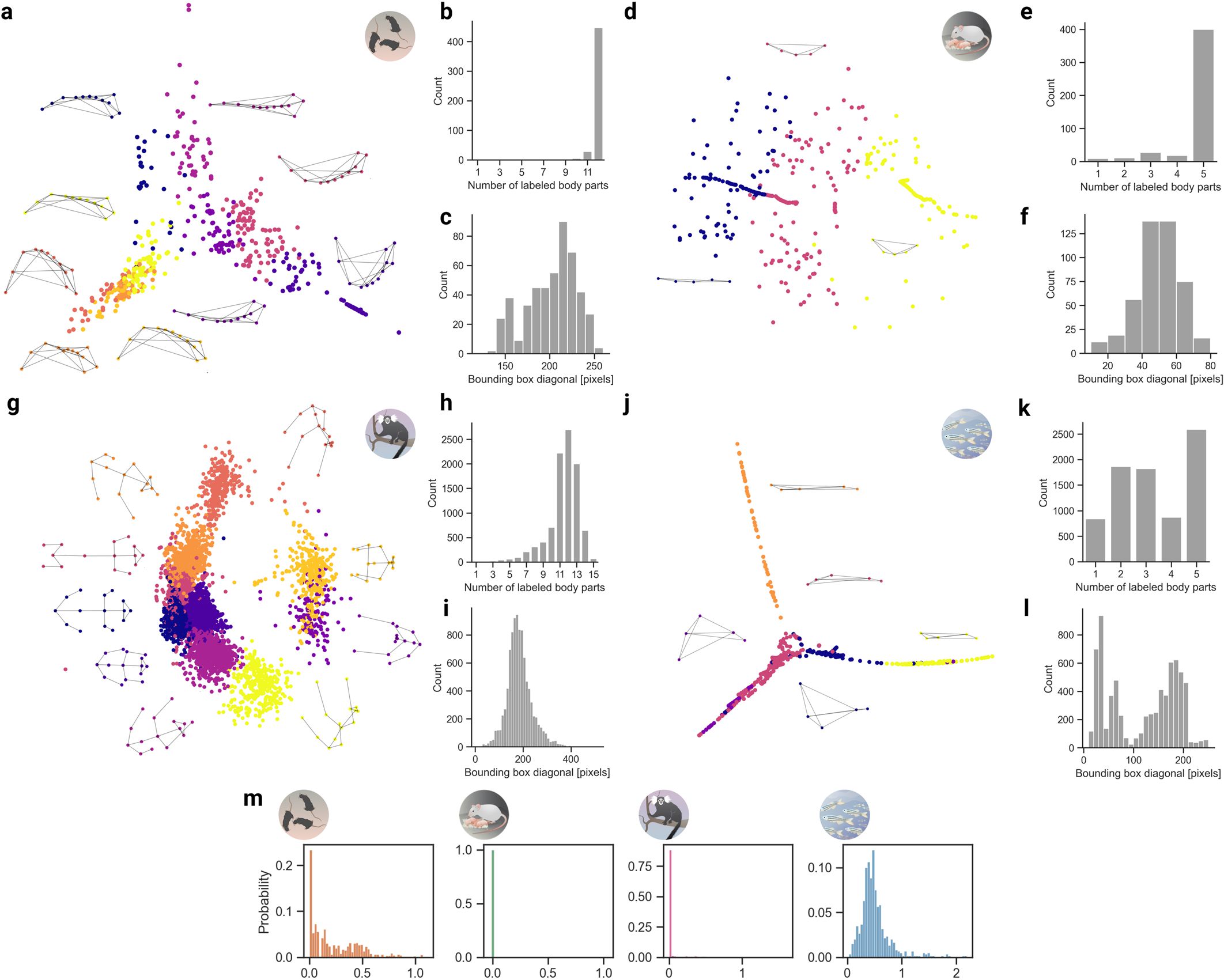

Per affrontare questo challenge, hanno prima creato quattro set di dati di varia difficoltà per il benchmarking delle reti (il processo sistematico di valutazione della validità dei prodotti, servizi e processi) di “stima della posa” di più animali.

Innovativa cura per l’artrite che abbina calore e ginnastica

Collaborazione per il benchmarking con il MIT e con Harvard

I set di dati, raccolti con i colleghi del MIT e dell’Università di Harvard, consistono nell’esame di tre topi in un campo aperto, topi genitori in una gabbia che funge da tana, coppie di uistitì pigmei alloggiati in un grande recinto, e quattordici pesci in un serbatoio di flusso.

Con questi set di dati in mano, i ricercatori losannesi sono stati in grado di sviluppare nuovi metodi per affrontare le difficoltà del monitoraggio del mondo reale.

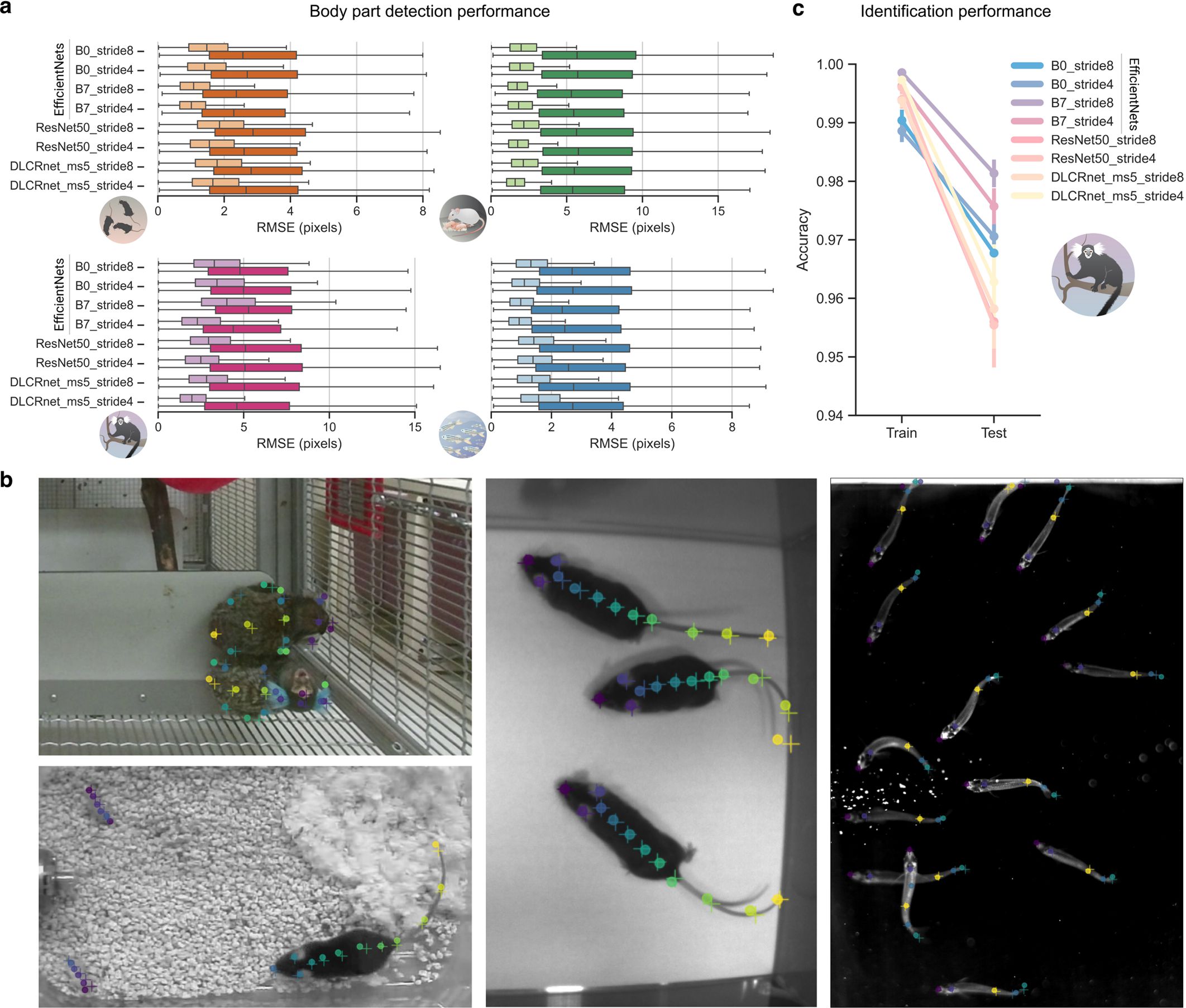

DeepLabCut affronta queste sfide integrando nuove architetture di rete, attraverso un assemblaggio guidato dai dati (quale punto chiave appartiene a quale animale) e metodi di tracciamento della posa su misura.

In particolare, i ricercatori hanno creato una nuova rete neurale multi-task che predice i punti chiave, il movimento degli arti e l’identità dell’animale direttamente dai singoli fotogrammi.

Hanno anche sviluppato un algoritmo di assemblaggio che è “agnostico” o indifferente al piano del corpo, che è molto importante quando si lavora con animali la cui forma corporea può variare ampiamente. Questi metodi sono stati convalidati sui piani dell’organismo di pesci e primati.

Inoltre, gli scienziati hanno sviluppato un metodo per identificare i singoli animali dal video senza alcun dato di identità “ground truth”.

“Immaginate la difficoltà di etichettare in modo affidabile quale sia il topo da laboratorio”, dice Mackenzie Mathis. “Sembrano così simili all’occhio umano che questo compito è quasi impossibile”.

Un lampone di… silicone per istruire i robot alla raccolta

Possibilità di ri-identificare l’animale in gruppo, o se… scompare

Il nuovo algoritmo si basa su un apprendimento metrico con trasformatori di visione, e permette agli scienziati di ri-identificare persino gli animali e di continuare a seguirli quando più animali si nascondono alla vista e riappaiono in seguito.

I ricercatori hanno anche usato un approccio basato sull’aspetto dell’essere vivente per analizzare il comportamento di coppie di uistitì pigmei attraverso nove ore di video, cioè quasi un milione di fotogrammi.

Una delle intuizioni di questo approccio è stata che gli uistitì pigmei, una specie altamente sociale, amano guardare insieme in direzioni simili.

“Centinaia di laboratori in tutto il mondo stanno utilizzando DeepLabCut, e lo hanno usato per analizzare tutto, dalle espressioni facciali nei topi, ai conseguimenti dei primati”, dice Alexander Mathis.

“Sono davvero impaziente di vedere che cosa farà la comunità (scientifica, ndr) con la ‘cassetta degli attrezzi” accresciuta che abbiamo messo a sua disposizione e che consente l’analisi delle interazioni sociali!”.

Quando è la luce a migliorare la resa dei circuiti integrati

Potresti essere interessato anche a:

Stati Uniti: Grana Padano protagonista della ristorazione

Il Consorzio di Tutela vola a San Antonio per la prima tappa di una campagna che sensibilizza i consumatori sul tema dell’Italian Sounding

Deep Sea Mining, la corsa all’oro che minaccia le balene

L'allarme degli scienziati: se l’ISA darà il via libera all’estrazione di minerali sui fondali marini ci saranno conseguenze catastrofiche...

Tutta l’innovazione dell’approdo del Gruppo Chery in Europa

Il 4 luglio i brand cinesi Omoda e Jaecoo hanno fatto il loro debutto a Milano e sul nostro mercato con auto sostenibili e al passo dei tempi

Le sostanze chimiche degli pneumatici finiscono nel nostro cibo

Uno studio austriaco dimostra che gli additivi sprigionati dall’usura delle gomme su strada finiscono nelle verdure in vendita al supermercato